1213组会汇报

Done:

- PGAN 训起来了,用的 AiShell所有 train 训练集,测试集没混进去

- Deep Voice 的 train1 提取 ppgs 的网络也训起来了,用的Timit,自带 Phonetic 信息

- VCTK-Corpus-0.92.zip 还在043下载,速度比较慢

Did & Doing:

- StarGAN-VC 2 的复现环节,

- 把 G 和 D 网络结构写好了,还差 一个 dataloader 写一下,另外 Solver 部分模仿着写一下就差不多了

- 特征用的是 PGAN 处理的方式(整体训练集做 均值&方差 归一化处理),为了和后端配合上,直接用vocoder的训练数据

- 🌟困难点:

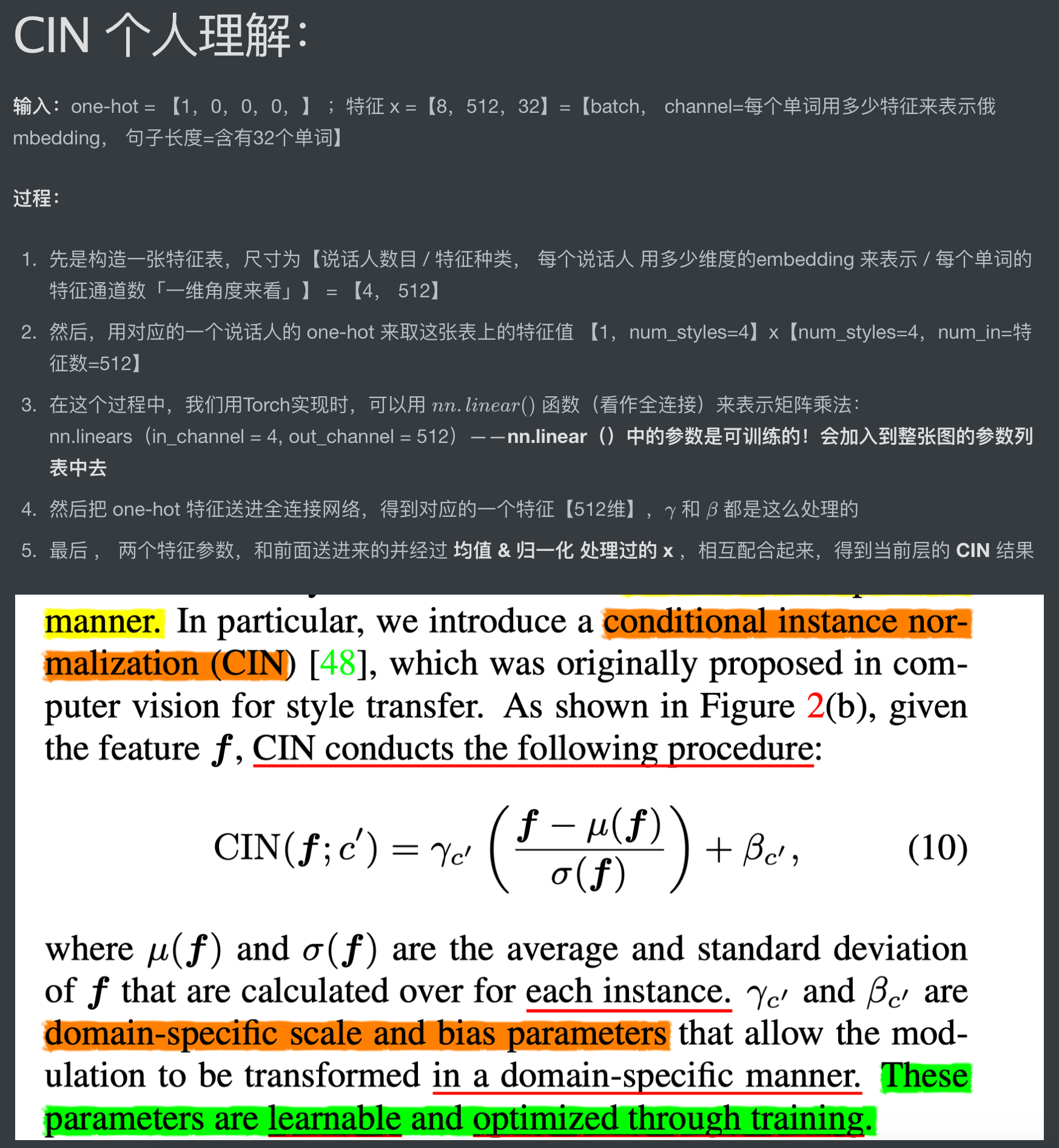

- 跟进了 CIN 在图像领域的具体实现,照猫画虎写出来(IN的改进,加上 特征偏置)

- 论文中提到的 GSP ,查了别人不同版本代码,挑了一个合适的方式移植进来

- 论文的尺寸结构 是【36维,128帧】,和咱们 mel 80 不对等,进行尺寸匹配计算

论文方面:

近期看到很多围绕

“Speaker embedding 循环损失”

- 「OPTIMIZING VOICE CONVERSION NETWORK WITH CYCLE CONSISTENCY LOSS OF SPEAKER IDENTITY」

❤️ “stargan-vc2 进一步改造”、——(投到了 2021 icassp)

WEIGHT ADAPTIVE INSTANCE NORMALIZATION(WAStarGAN-VC)

「TOWARDS LOW-RESOURCE STARGAN VOICE CONVERSION USING WEIGHT ADAPTIVE INSTANCE NORMALIZATION」

“PPG实现多对多转换” 「Phonetic Posteriorgrams based Many-to-Many Singing Voice Conversion via Adversarial Training」的论文

主要的创新点都不多,其中 stargan-vc2改进,基于的是 其中提到的 CIN 结构,再把 one-hot 类型改进成 同步训练的 Speaker Encoder 出来的 Speaker Embedding 来改;但是声码器还是用的 WORLD

- 咱们的想法算是综合上面两篇

(论文具体细节内容还没全部看完,接下来看一下)

下周安排

- 把 dataloader 和 solver 尽快写完,让代码先跑通

- 先试 one-hot 类型的,再试 AiShell3 的 Speaker encoder 方式提取的【256】维 embedding

- 嵌入 embedding 两个可能的实现方式路线:

- 同样用 CIN;但是感觉不太符合 CIN 本意是针对 one-hot 而设计的初衷

- 不用CIN,直接在 通道层 方向上拼接:像一代那样,但是 2 代 这里已经 reshape 成一维卷积层了

- 可以分别做实验看效果,或者直接选第二个就好

- 嵌入 embedding 两个可能的实现方式路线:

- 再跟进一下 看近期有没有新的针对 「隐变量」路线的VC论文的代码